深層学習を用いたAI開発において、ネットワークの学習過程で発生する「勾配消失問題」は大きな課題です。この問題が発生すると、AIの学習が停滞し、予測精度が低下する可能性があります。

しかし、この問題を理解し、適切な対策を講じることで、効率的な学習が可能となります。

この記事では、勾配消失問題の原因とその解決策についてわかりやすく解説します。AI開発者だけでなく、AIの活用を考えている方にとっても有益な情報を提供するので、ぜひ参考にしてみてください。

株式会社Jiteraでは、要件定義を書くだけでAIが生成するツールで、アプリ・システム開発を行っています。制作している途中で要件が変更になっても柔軟に修正しながら開発できるので、アプリ開発・システム開発のご相談があればお気軽に相談ください。

東京都在住のライターです。わかりづらい内容を簡略化し、読みやすい記事を提供できればと思っています。

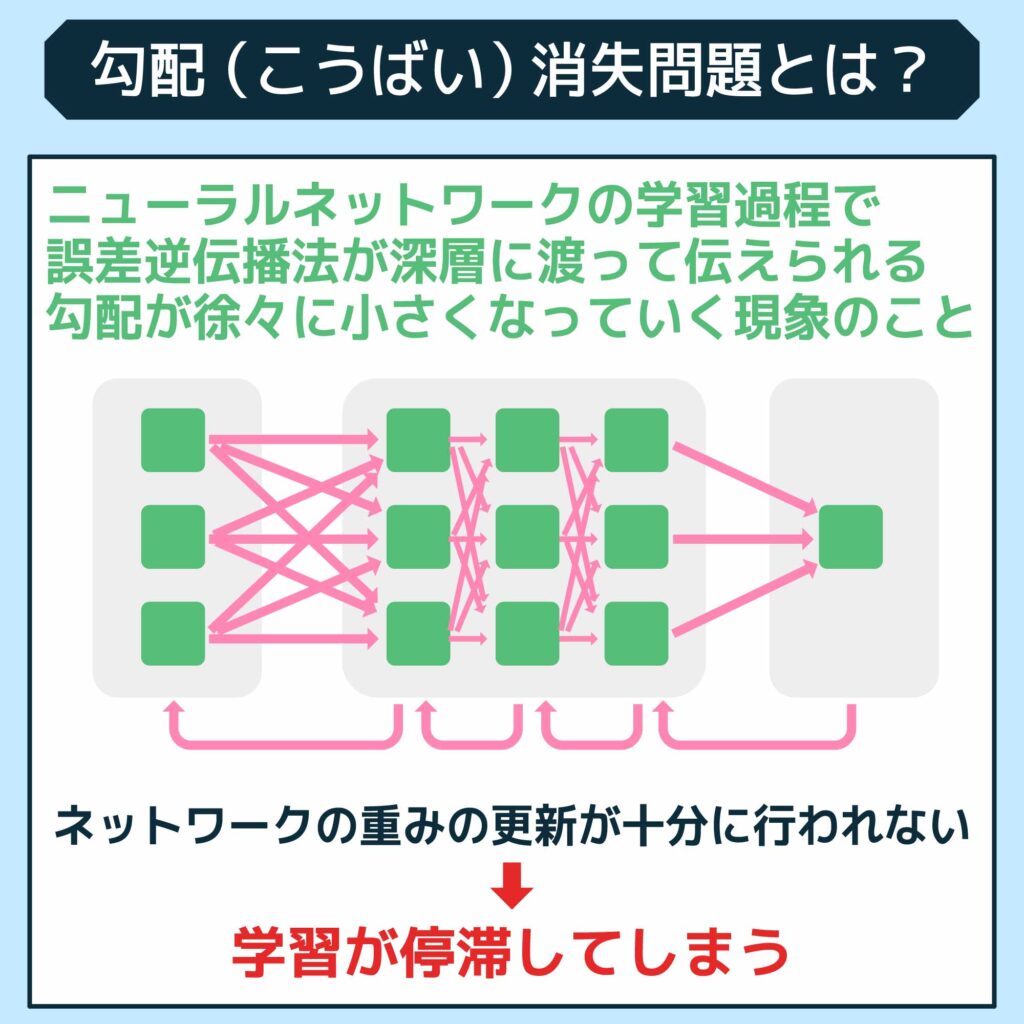

勾配(こうばい)消失問題とは?

勾配消失問題とは、ニューラルネットワークの学習過程において、誤差逆伝播法が深層に渡って伝えられる勾配が徐々に小さくなっていく現象を指します。

この問題が発生すると、ネットワークの重みの更新が十分に行われなくなり、学習が停滞してしまいます。

なぜこのような現象が起こるのでしょうか? 主な理由は、活性化関数と重みの初期値にあります。

特に、シグモイド関数やハイパボリックタンジェント関数のように、出力値の範囲が限られている活性化関数を使用すると、勾配が小さくなることが多いです。

たとえば、あるネットワークでシグモイド関数を使用していたとします。この関数の導関数は最大でも0.25であり、層を重ねるごとにこの値が乗算され続けるため、非常に速く勾配が小さくなってしまいます。具体的には、10層あるネットワークの場合、勾配は\(0.25^{10}\)となり、非常に微小な値になることが予測されます。

この問題に対処する方法として、ReLU(ランプ関数)のような別の活性化関数を用いる、勾配のクリッピングを行う、適切な重みの初期化方法を選ぶ、などが挙げられます。これにより、勾配が消失することなく、効率的にネットワークが学習できるようになります。

勾配消失問題を理解し、適切な対策を講じることは、深層学習のモデル設計において非常に重要です。モデルの深さに応じた適切な活性化関数の選択や初期化方法を考慮することが、成功に繋がる鍵となります。

また、以下の記事では、畳み込みニューラルネットワークの仕組みについて紹介しています。機械学習を行う上では必要不可欠な知識ですので、ぜひ参考にしてみてください。

勾配消失問題の主な原因は活性化関数

勾配消失問題は深層学習における一般的な問題で、主な原因は活性化関数にあります。この問題を理解し、対策を講じることで、効率的な学習が可能となります。

勾配消失問題がディープラーニングで問題になる理由

勾配消失問題がディープラーニングで問題になるのは、この現象が学習プロセスを妨げ、最適な重みを見つけることが困難になるからです。

特に深層ニューラルネットワークでは、誤差が逆方向に伝播する際に、勾配が急速に小さくなり、重みの更新が微小になってしまいます。

たとえば、深いネットワークでは、初期層の重みが十分に調整されず、モデルの学習が効果的に進まないことがあります。その結果、ネットワークの性能が著しく低下し、学習が長引く原因となります。

この問題に対応するため、適切な活性化関数の選択や、重みの初期化方法を工夫することが求められます。

勾配消失問題による具体的な影響

勾配消失問題が起こると、それが影響を及ぼすニューラルネットワークを使っているさまざまなアプリケーションやサービスにおいて問題が生じる可能性があります。

ここでは、勾配焼失問題における具体的な影響の例を4つ解説します。

- 自動運転車

- 医療画像診断

- 会話型AI

- データ分析と予測

それぞれ詳しく解説します。

自動運転車

勾配消失問題は自動運転車の技術においても重大な影響を及ぼします。

自動運転車は周囲の環境を正確に認識し、適切な行動を取るために、ディープラーニングが中核技術として活用されています。このプロセスでは、複数のセンサーやカメラが捉えたデータを基に、車両が判断を下す必要があります。

しかし、勾配消失問題が発生すると、ディープラーニングモデルの学習プロセスが停滞し、車両の認識システムが正確に学習できなくなる可能性があります。

具体的には、他の車両や歩行者、交通信号などを認識する際に、必要な特徴を捉えられず、それが原因で誤った判断をするリスクが高まります。

たとえば、勾配消失により、遠くの物体や小さな物体の識別が不十分になることが考えられます。

これにより、自動運転車が適切な時間にブレーキをかけることができず、事故を引き起こす可能性があります。また、交差点での信号の誤認識や、急な障害物に対する反応の遅れなど、安全性に直結する問題が生じることもあります。

このような問題を回避するためには、ディープラーニングモデルの設計段階で勾配消失に対する対策を施すことが重要です。

適切な活性化関数の選択や重みの初期化方法、勾配のクリッピングなどの技術を用いることで、学習プロセスを安定させ、自動運転車の認識精度を高めることができます。

医療画像診断

勾配消失問題は医療画像診断の分野にも影響を及ぼします。医療分野ではディープラーニングを用いて病変の識別などが行われますが、勾配消失により学習が進まない場合、診断精度が低下する恐れがあります。

特に、がんの早期発見など、正確な診断が求められる場面での影響は大きく、患者の治療機会を逸する可能性があります。そのため、効果的な学習方法の選定が重要です。

会話型AI

勾配消失問題は会話型AIの効果にも大きな影響を与えます。これらのAIは、ユーザーの質問に対して適切に答えるために、複雑なニューラルネットワークを使用しています。

しかし、勾配消失が起きると、これらのAIシステムが適切に学習できなくなり、結果としてユーザーの問いに対して不適切または無関係な回答をしてしまうことがあります。

たとえば、ユーザーが特定の情報を求めている際に、学習が不十分なために全く異なるトピックの情報を提供するなど、コミュニケーションの質が低下します。

このような問題はユーザーの満足度を著しく低下させるため、AI開発者は活性化関数の選択や学習プロセスの最適化に注意を払う必要があります。

データ分析と予測

金融市場の動向予測や製品の需要予測など、ディープラーニングが広く使用されているこれらの分野では、正確な予測がビジネス成功の鍵を握っています。しかし、勾配消失によりニューラルネットワークの学習が停滞すると、予測の正確性が大幅に低下します。

たとえば、金融市場で不正確な予測がなされると、投資戦略が誤った方向に導かれ、結果的に重大な損失を引き起こす可能性があります。

同様に、製品の需要予測が不正確であれば、過剰在庫や供給不足の問題が発生し、企業の財務に大きな影響を与えることになります。

これを防ぐためには、勾配消失問題に対応するための技術的な改善が必要です。

勾配消失問題を解決する4つの方法

続いて、勾配消失問題を解消する4つの方法を紹介します。

- 勾配クリッピングを実施する

- 適切な重みを初期に設定する

- 活性化関数を選択する

- ネットワーク構造を工夫する

それぞれ詳しく解説します。

勾配クリッピングを実施する

勾配消失問題を解決する方法の1つは、勾配クリッピングを実施することです。この技術は、勾配がある閾値を超えた場合に大きさを制限することで、勾配の爆発を防ぎつつ、消失を防ぐ効果があります。特に、ニューラルネットワークが深い場合や複雑なデータを扱う場合に有効です。この方法により、学習プロセスが安定し、モデルの収束速度を改善できます。

適切な重みを初期に設定する

勾配消失問題を解決するためには、適切な重みの初期設定が非常に重要です。重みを適切に初期化することで、ニューラルネットワークの各層を通じて勾配が適切に伝播しやすくなります。

具体的には、He初期化やXavier(グロロット)初期化など、活性化関数に応じた初期化方法を選択することがおすすめです。これらの作業を行うことで、学習の効率が向上し、ネットワークがより早く収束する可能性が高まります。

活性化関数を選択する

適切な活性化関数を選択すれば、勾配焼失問題を緩和できます。ここでは、主な4つの手法を紹介します。

- tanh関数

- ReLU関数

- シグモイド関数

- ステップ関数

それぞれ詳しく解説します。

tanh関数

勾配消失問題に対処するために、tanh関数を活性化関数として選択する方法があります。tanh関数は、出力が-1から1の範囲に収まるため、中心化が行われている点が特徴です。これにより、ニューラルネットワークの学習初期段階での勾配の効率が向上し、学習プロセスが安定する可能性があります。

ただし、tanh関数は深い層を持つネットワークでは、依然として勾配消失の問題が生じることがあります。そのため、この関数を用いる場合は、ネットワークの深さやその他の学習パラメータにも注意を払いながら適用する必要があります。より深いネットワークにおいては、ReLUやその派生形など他の活性化関数の検討も考えられるでしょう。

ReLU関数

ReLU(Rectified Linear Unit)関数は、勾配消失問題の解決に効果的な活性化関数として広く採用されています。この関数の最大の特徴は、正の入力に対してはそのままの値を出力し、負の入力に対しては0を出力することです。この性質により、勾配が正の範囲であれば勾配消失を防ぎつつ効率的な学習が促進されます。

ReLUのシンプルな計算式は、学習プロセスを高速化する効果もありますが、負の入力が完全に無視されるために常に0を出力し、それ以上学習が進まなくなる「死んだニューロン」という問題が生じることがあります。

この点を補うために、Leaky ReLUやParametric ReLUなどの変種が開発され、より幅広い分野での利用が進んでいます。

シグモイド関数

シグモイド関数は古典的な活性化関数で、出力を0から1の範囲に収める特徴があります。この関数は初期のニューラルネットワークで広く使用されましたが、深い層を持つネットワークでは勾配消失問題を引き起こす可能性が高いです。

これは、シグモイド関数の導関数が最大でも0.25であり、層を重ねるごとに勾配が急速に小さくなるためです。

ただし、シグモイド関数は出力層での確率的なタスクや、バイナリ分類問題においては依然として有効な選択肢です。適切な場面で使用することで、その特性を活かし学習プロセスに適用することが可能です。

ステップ関数

ステップ関数は、特定の閾値を超えた入力に対して1を、それ未満の入力に対して0を出力する非常にシンプルな活性化関数です。

しかし、ステップ関数の主な問題点は、その導関数がほとんどの場所で0となるため、勾配消失問題を引き起こしやすいことです。これにより、ニューラルネットワークが学習中に適切な重みの更新を行えなくなる可能性があります。

そのため、ステップ関数は現代のディープラーニングモデルではあまりおすすめできず、勾配消失問題を避けるためにはReLUやその他の連続的な活性化関数を活用するのがおすすめです。

ネットワーク構造を工夫する

勾配消失問題を解決するためには、ネットワーク構造を工夫することも効果的です。具体的には、残差ネットワーク(ResNet)のようなアーキテクチャが有効です。

これらのネットワークでは、入力を層をまたいで直接次の層に伝えるスキップ接続(ショートカット接続)を用いることで、勾配が深い層まで効果的に伝播されるように設計されています。

スキップ接続により、深いネットワークでも勾配が消失することなく、安定して学習を進めることが可能になります。これにより、ネットワークはより複雑な機能を学び、高い精度でタスクをこなすことができるようになります。

このアプローチは、特に画像認識や音声認識などの複雑な問題において有効です。

まとめ:勾配消失問題

この記事では、深層学習における重要な課題である勾配消失問題について詳しく解説しました。

勾配消失問題とは、ニューラルネットワークが深くなるほど勾配が小さくなり、重みの更新が十分に行われない結果、学習が停滞するという現象を指します。主な原因は活性化関数と重みの初期値にあります。

勾配消失問題は、自動運転車、医療画像診断、会話型AI、データ分析と予測など、さまざまなアプリケーションやサービスに影響を及ぼす可能性があります。その解決策としてこの記事では以下の内容を紹介しました。

- 勾配クリッピングの実施

- 適切な重みの初期設定

- 活性化関数の選択

- ネットワーク構造の工夫

これらの対策を講じることで、勾配消失問題を克服し、効果的な深層学習のモデル設計を行うことが可能になります。今回ご紹介した内容も参考にしてみてください。

また、Jiteraでは、要件定義を書くだけでAIがアプリ・システムを開発するプラットフォームJiteraを軸としてアプリ・システム開発を行っています。AI関連の開発案件がございましたら、ぜひJiteraにご相談ください。