AIを活用している企業が増えています。AIは企業の業務を進める中で、業務の効率化において重要な技術と言えます。

そのAIに対して、脅威となる手法が話題になっています。それが今回紹介する敵対的サンプルと呼ばれるものです。

敵対的サンプルはAIを誤認させる事により、さまざまな脅威を生み出します。この敵対的サンプルは、一見すると人間では大体のものはわかるのですが、AIが判断を間違えてしまうのです。

今回はそんな敵対的サンプルについて、具体例の紹介や攻撃の対処法などについて、徹底解説していきます。

某電子専門学校卒業後、サーバー/ネットワーク運用業務を通し、ネットワーク設計/構築事業をメインにインフラ業務全般を担当。その後、某情報セキュリティ会社にて、情報セキュリティ教育事業の教育係も担当。

敵対的サンプルとは?

ここでは冒頭にて紹介しました敵対的サンプルについて、どのような手法なのか、その影響について説明します。

敵対的サンプルは、簡単に言うと、AI技術の弱点をついた攻撃手法です。その攻撃手法は、AIがどうしたら誤認するのか、に重きをおいて作られたコードを悪用します。

敵対的サンプルの主な攻撃は、FGSMと呼ばれるものになります。AIに入力される画像に対して、第三者がある一定の式を入力させる事で、AIを誤認させます。

また、敵対的サンプルによる攻撃は、すぐに気づくことが難しい点と、証拠となるものがほぼ無いため、いつ、どのハッカーが敵対的サンプルによる攻撃を行ったのか、判断が難しいという特徴があります。

FGSM(Fast Gradient Sign Method)とは?

まず敵対的サンプルの攻撃手法の中で最もよく知られている、FGSMについて説明します。

敵対的サンプルは、AIに入力させる要素を誤認識させ、AIがそれを事実のように認識してしまいます。

そして、FGSMは主に画像のデータの中にある、損失による匂配を悪用することで、AIに入力させる画像をFGSM攻撃により、別の物にすり替えるのです。AIが入力された画像を別の画像と認識せずに、正しい画像と誤って判断してしまうという問題が発生しています。

特徴としては、AIに対して、入力画像の匂配の損失を最大化させます。その画像を作成することで、AIに誤認識させることを目的としているのです。これが、FGSM攻撃の全貌となります。

悪質な事にこのFGSM攻撃は、チェーンルールを使用することで、匂配の損失を効率的に拡大化する為、処理がとても高速です。それ故に、管理者がすぐに気づくことが難しいです。さらにAIに入力されるモデルパラメーターは、一切の変更が無い為、変化に気付きにくい点があります。

敵対的サンプルによる攻撃の影響

敵対的サンプルによる攻撃の影響は、さまざまにあります。

例えば一般的な企業であれば、社員証によるセキュリティロックを、敵対的サンプルにより企業の社員ではない人間が入室することを可能としたり、データセンター等で侵入してはいけない場所に、敵対的サンプルを使用することで、侵入検知システムを誤検知させ、データセンターで違法な行為をさせてしまう、などです。

さらに現代のPCにおいても、敵対的サンプルによる攻撃に影響が出ています。代表的な例としては、マルウェアによるPCの乗っ取りです。PCに搭載されているセキュリティソフトウェアのセキュリティホールを通じてPCを改ざんしてしまうなどが挙げられます。

敵対的サンプルによる具体的な攻撃事例

ここでは敵対的サンプルを使用した、具体的な攻撃について、事例をまじえて詳しく解説していきます。敵対的サンプルは特徴として、限定的な場面ではなく様々なシーンで攻撃を行い、違法な行為を可能としています。

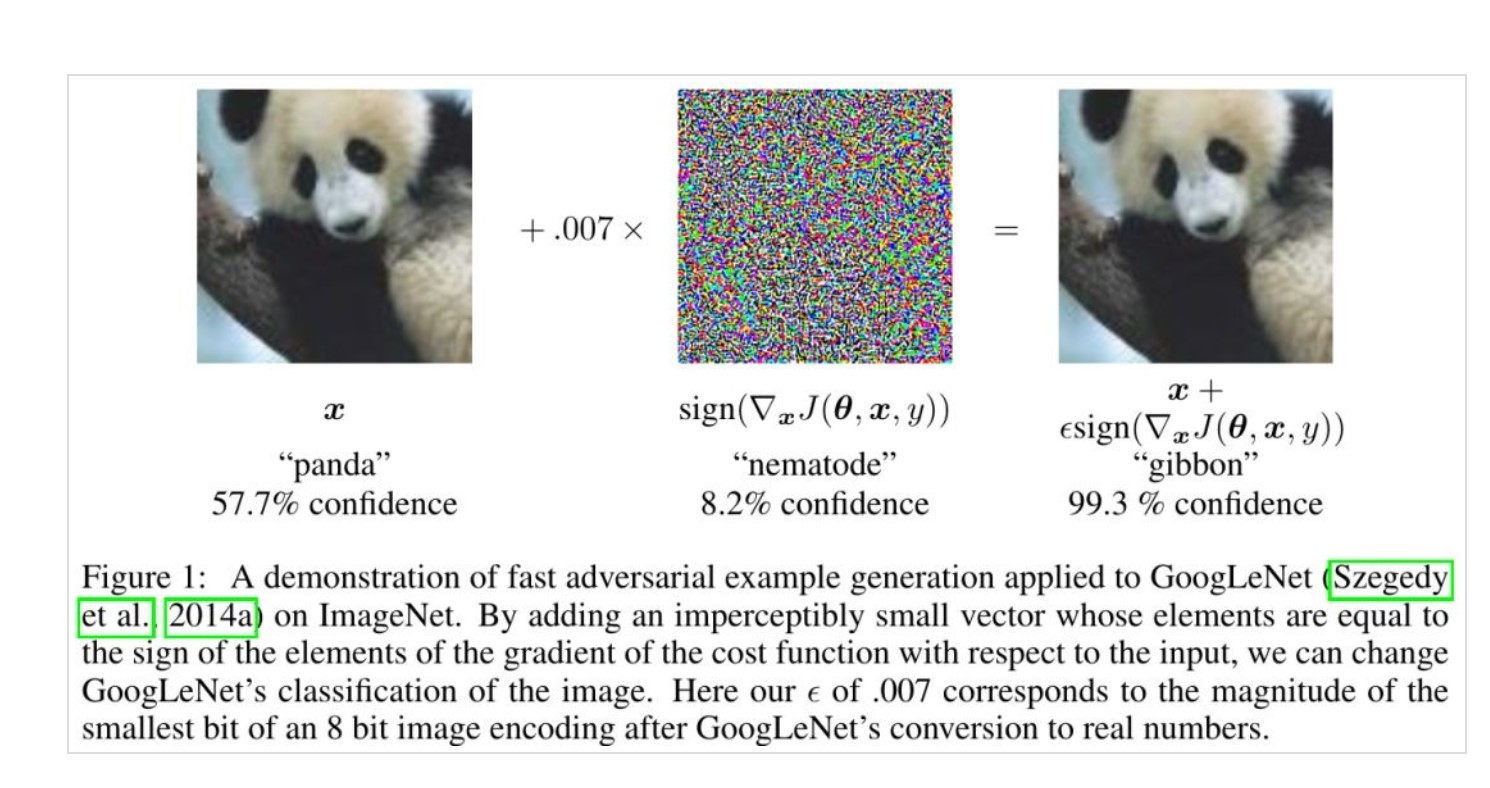

グーグルの画像認識システム

まずGoogleの画像認識システムを悪用した事例を紹介します。上記の画像が、実際に敵対的サンプルを使用した攻撃の画像です。

一見人間から見ると、左と右の画像共に同じパンダの画像のように見えます。

そして、この右の画像が、敵対的サンプルを使用した攻撃手法の一つである、FGSMを使用することで、AIをハッキングしたものです。どのようにハッキングしているかというと、左のパンダの画像に匂配による損失を最大化し、AIにテナガザルと認識させ、AIを騙しているのです。

さらに具体的に言うと、この中央にある敵対的サンプルの計算式を入力させる画像に読み込ませ、AIに対してハッキングしています。これがGoogleの画像認識システムのAIに対しての攻撃手法の一例です。

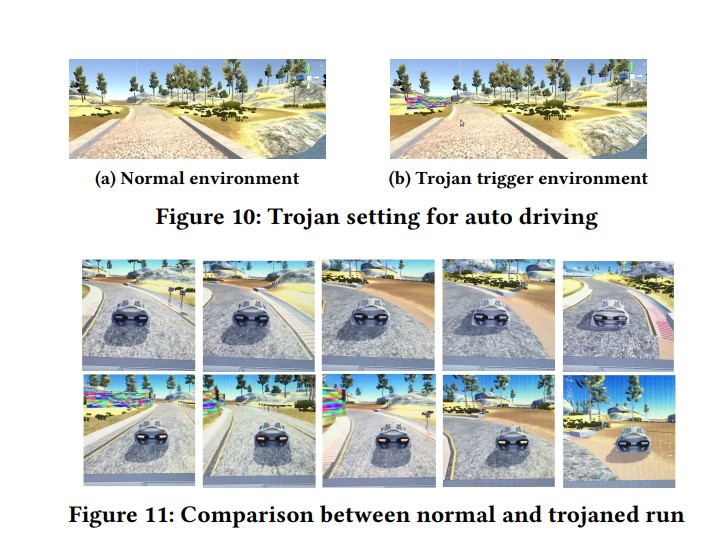

自動運転車に対する攻撃

次に自動車運転に対しての攻撃についての事例です。

とある自動車メーカーで、自動運転のディープランニングを行った自動車に対して、敵対的サンプルを使用することで、ディープランニング自体を汚染させ、ドライビングを狂わせてしまった、という事例があります。

どのような攻撃手法かというと、上記の画像の上段にある(b)の画像を、ドライビングしているAIに読み込ませる事により、AIが勝手に(b)の画像を再学習してしまい、結果的に想定したドライビングをせず、自動運転が上手くいかなかったというものです。(b)の画像には赤緑の看板のようなものがあり、それをAIが誤検知してしまう、という事かと思われます。

音声認識システムに対する攻撃

最後の事例として、音声認識システムに対する攻撃について解説していきます。

今度はスマホの充電器から敵対的サンプルによる攻撃で、音声アシスタントを操作して違法な行為をしてしまうという事例です。

具体的に書くと、スマホやテレビなど、電化製品に搭載されている、スイッチング電源と呼ばれるものに音を出力させることで、音声アシスタントに、人間から何か音声を入力されたと誤検知させることで、意図しない操作を行わせ、違法な行為をするといった攻撃手法です。この

攻撃の厄介な点は、ハードウェアの改造をする必要が無いため、証拠となるものを見つけづらいという点があります。

敵対的サンプルの防御策

ここまで敵対的サンプルとは何か、敵対的サンプルによる攻撃の手法はどのようなものか、その攻撃事例にはどのようなものがあるか、について解説していきました。ここでは敵対的サンプルにおいて、どのような防御策があるかについて、

・アンサンブルメソッド

・専門的な対策ツールの使用

これら三つの手段を解説していきます。

敵対的トレーニング

まず敵対的トレーニング(または敵対的学習)と呼ばれる防御手法について、解説します。

敵対的トレーニングは、学習中のAIに、正常な値と、敵対的サンプルを同時に学習させることにより、敵対的サンプルによる誤検知を未然に防ぐといった防御手段です。

具体的に言うと、AIに学習させた正常値と敵対的サンプルに、それぞれに損失値を入力させ、それぞれの損失値の誤差を最小にすることで、AIの誤認識を防ぎます。

ただし、さまざまな情報の正常値とともに、多くの敵対的サンプルの作成から機械学習をトレーニングする為、長い時間がかかるというデメリットがあります。

アンサンブルメソッド

次にアンサンブルメソッドと呼ばれる防御手法について解説します。

アンサンブルメソッドは、アンサンブルという名のように、AIに対して複数のモデル搭載させ、AIが敵対的サンプルに対してこれは正しい情報か、間違った情報かといった判断を、多数決によって予測することで、AIの精度を高め、敵対的サンプルによる攻撃を防ぐといったものです。

モデル一つ一つの精度が高くないのが、AIの特徴とも言えるのですが、複数のモデルの多数決により、より高い精度になるというAIの特徴を活用した防御手法です。

また、アンサンブルメソッドは、さらに細かく言うとバギング、ブースティング、スタッキングという3つの手法に分かれます。

専門的な対策ツールの使用

ここまで敵対的トレーニング、アンサンブルメソッドと呼ばれる防御手法について説明してきました。確かにこれらの防御手法で、敵対的サンプルによる攻撃から防御できますが、多くの時間と多額のコスト、さらに専門的な知識が必要となってきます。

特に立ち上げたばかりの企業や、専門的な知識があるエンジニアがいないケースもあります。そのような場合、以下の対策ツールを活用しましょう。

IBM Adversarial Robustness Toolbox

IBM Adversarial Robustness Toolboxは、IBM社が総合技術サイトのGitHub上で提供している機械学習セキュリティのツールです。

主にPythonを使用する事で動作します。物体検出、オブジェクト追跡、音声認識など、AIに入力される敵対的サンプルに対して、さまざまな防御手法を、AIに学習させることができます。

さらに、対応している機械学習ライブラリも、TensorFlow v1及びv2、ケラス、MXNetなど、これら以外にもさまざまに対応しているので、敵対的サンプルによる攻撃から守りたいと考えている場合は、このツールを使用するとよいでしょう。

CleverHans

CleverHansは、先ほど紹介したIBM Adversarial Robustness Toolboxと同様に、GitHub上で公開されている敵対的サンプルに対しての防御ツールです。

特徴としては、柔軟性に特化していて、使いやすいということと、とても軽量な点が挙げられます。

さらに、コードが簡潔で読みやすい為、あまりコードについて詳しくない方でも、比較的導入しやすいツールと言えます。

CleverHansは、MNISTと呼ばれるデータセットをダウンロードし、AIに学習させることで、AIの誤検知を最小限に留めるのです。ダウンロードしたデータセットをさらに敵対的サンプルに対して強化することもできます。

| 項目 | IBM Adversarial Robustness Toolbox | CleverHans |

| ソースコードの記載の柔軟性 | とても高い | やや高い |

| コードの記載難易度 | 難しい | 簡単 |

| データ容量 | やや重い | 軽い |

敵対的サンプルのまとめ

敵対的サンプルとは何か、どういった攻撃をするのか、その事例から防御策について、詳しく解説していきました。

AIは今後さまざまな企業で導入されていき、業務の効率化に繋がると言えますが、インフラと同じように点検やセキュリティに対しての対策はしっかりしておく必要があると言えます。

Jiteraであれば、AIを使用した開発実績でのノウハウから、敵対的サンプルに対してどのようにすればよいか、提案してもらえます。もし敵対的サンプルに対して懸念があるのでしたら、以下のボタンから株式会社Jiteraに相談してみるとよいでしょう。

株式会社Jiteraに相談する