AI技術の進化に伴い、転移学習はビジネスや研究の領域で大きな注目を集めています。

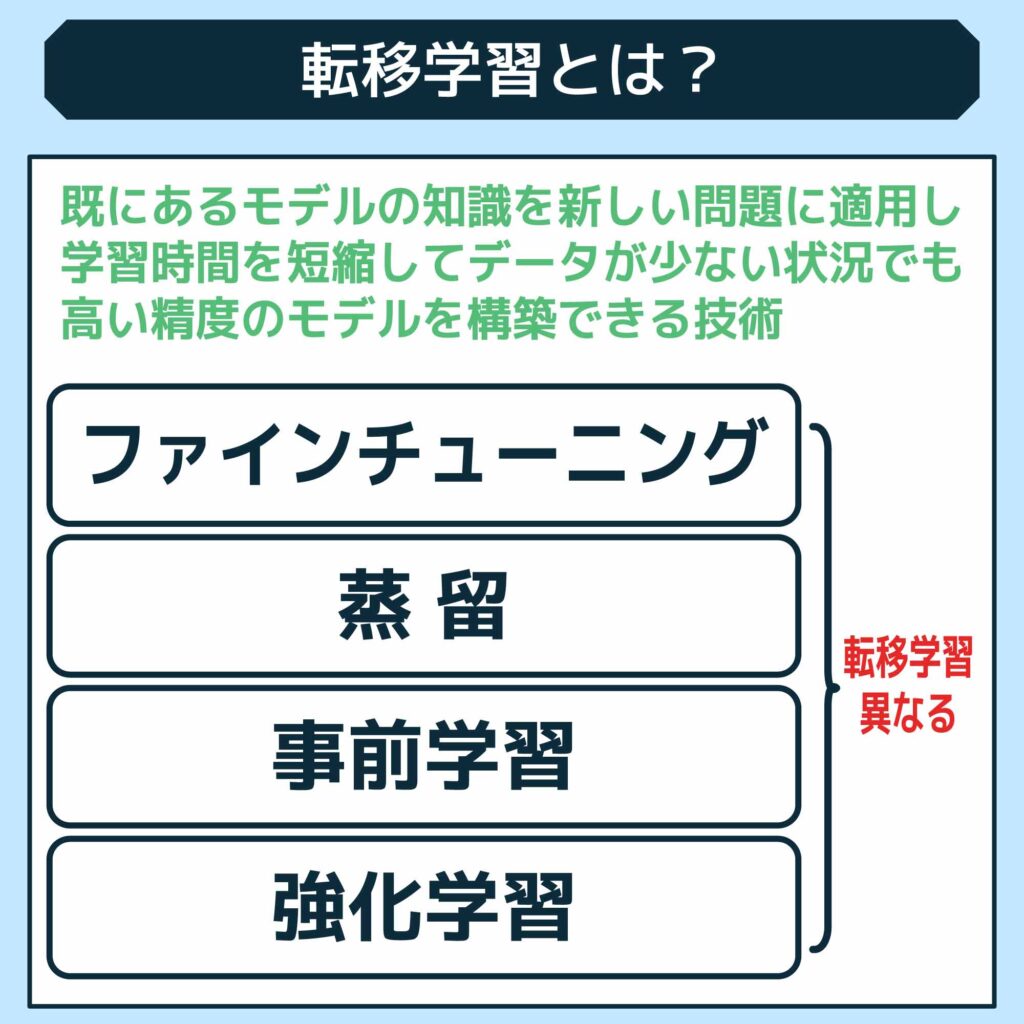

転移学習とは、既にあるモデルの知識を新しい問題に適用することで、学習時間を短縮してデータが少ない状況でも高い精度のモデルを構築できる技術です。この手法により機械学習プロジェクトの効率が大幅に向上し、多様な業界で利用され始めています。

この記事では、初心者でも理解しやすいように転移学習の基本概念からそのメリット、具体的な活用事例に至るまで一貫して解説していきます。

転移学習のやり方からメリット、さらには注意点までを本記事を通じて具体的に学んでいきましょう。

高校からHTML/CSS/COBOL/C++/Rubyに触れ、システム管理やCMSなど幅広く網羅。建築士から転身し、Webメディアの制作を主軸とした会社を設立。ITパスポート所有。趣味は建築物巡り。

転移学習とは?仕組みを解説

転移学習とは、すでに他のタスクで学習されたモデルを使って、新しいタスクに適応させる方法です。

一般的に、モデルはゼロから学習を始めますが、転移学習では事前に大量のデータで学習されたモデルを利用するので、短い時間で効率よく結果を得られます。

たとえば、すでに画像を分類できるモデルを少し調整するだけで、別の種類の画像分類にも使えるようにすることができます。

仕組みとしては、まず学習済みのモデルを選び、その中で使える部分(例えば、画像なら基本的な形や線を見つける層)をそのまま活かします。

そして、新しいタスクに合わせて必要な部分を追加し、学習させます。

これにより、元々の知識を残しつつ新しい課題にも対応できるようになります。

データが少ない場合や、時間をかけずに成果を出したいときに便利な方法です。

転移学習と他のAI技術の違い

転移学習に似たAI技術として、ファインチューニングと蒸留、事前学習、強化学習があります。

ここでは、転移学習とそれぞれの技術がどのように違うのか、表を用いて解説します。

転移学習とファインチューニングとの違いは?

| 学習タイプ | 転移学習 | ファインチューニング |

| 定義 | あるタスクで得られた知識を別の関連するタスクに適用するプロセス | 事前学習されたモデルを新たなデータセットで微調整すること |

| 特徴 | ・モデルの一部または特徴を新たなタスクに再利用 ・新たなタスクに迅速に適応 ・データが少ない場合にも有効 |

・モデルの最後の層を新しいタスク用に調整 ・低データ環境でのパフォーマンス向上 |

| 一般的な応用例 | ・画像認識での種別識別

・自然言語処理での言語間翻訳 |

・犬の品種識別から猫の品種識別への適応 ・医療画像での特定病理の識別 |

転移学習とファインチューニングは、どちらも機械学習において既存の知識を新しい状況に応用する技術ですが、使用するアプローチに大きな違いがあります。

転移学習では一般的には事前に大量のデータで訓練されたモデル(ソースモデル)から有用な情報を抽出し、それを全く新しいが関連性のあるタスク(ターゲットタスク)に適用します。

このプロセスでは、ソースモデルの学習が完了した後に重要な特徴やパラメーターが新しいモデルに移されます。

一方、ファインチューニングは転移学習の一種と見なされることもありますが、より具体的な技術といえます。

ファインチューニングでは、事前訓練されたモデルをベースにして新たなデータセットに対して微調整を行います。

この過程では、元のモデルのパラメータを部分的に保持しつつ新しいデータに合わせて調整を加えるため、新しいタスクに対する精度を高めることができます。

つまり、ファインチューニングは転移学習の手法を用いて特定のタスクに特化させる過程と言えます。

転移学習と蒸留との違いは?

| 学習タイプ | 転移学習 | 蒸留 |

| 定義 | あるタスクで得られた知識を別の関連するタスクに適用するプロセス | 大規模なモデル(教師モデル)から小規模なモデル(生徒モデル)への知識の伝達 |

| 特徴 | ・モデルの一部または特徴を新たなタスクに再利用 ・新たなタスクに迅速に適応 ・データが少ない場合にも有効 |

・教師モデルの出力を模倣して生徒モデルを訓練 ・軽量なモデルへの効率化 |

| 一般的な応用例 | ・画像認識での種別識別

・自然言語処理での言語間翻訳 |

・モバイルデバイス向け軽量モデルの開発 ・リアルタイムアプリケーションへの応用 |

転移学習とは異なり、蒸留は知識の伝達と簡素化を目的としたプロセスです。

モデルの蒸留は、大規模で複雑なモデル(教師モデル)の知識をより小さくシンプルなモデル(生徒モデル)に移す技術です。

このプロセスでは、教師モデルが訓練データに対して行った予測を生徒モデルが模倣することで、教師モデルと同等の性能を持つように訓練されます。

そのため、計算資源が限られている環境でも高性能なモデルを利用できるようになります。

蒸留と転移学習の主な違いとしては、蒸留がモデルのサイズと複雑さを削減することに重点を置いている一方で、転移学習は異なる関連性のあるタスク間で知識を移転することに焦点を当てています。

蒸留は主に効率と実行速度を向上させるために用いられ、転移学習は新しいタスクに対するモデルの適用性を高めるために使用されます。

転移学習と事前学習との違いは?

| 学習タイプ | 転移学習 | 事前学習 |

| 定義 | あるタスクで得られた知識を別の関連するタスクに適用するプロセス | 大量のデータで一般的な特徴を学ぶためにモデルを訓練するプロセス |

| 特徴 | ・モデルの一部または特徴を新たなタスクに再利用 ・新たなタスクに迅速に適応 ・データが少ない場合にも有効 |

・汎用性の高い基盤モデルの作成 ・特定のタスクには後からファインチューニング |

| 一般的な応用例 | ・画像認識での種別識別

・自然言語処理での言語間翻訳 |

・大規模データセットでの言語モデルの訓練 ・様々なタスクへの応用可能 |

転移学習と事前学習はともに機械学習の効率化と性能向上を目的としていますが、そのアプローチ方法には明確な違いがあります。

事前学習は、一般的に大規模なデータセットを使用してモデルが広範な特徴を学ぶプロセスで、モデルが初めて遭遇する可能性のある様々なシナリオに対応するための基礎を築くことを目的としています。例えば、多種多様な画像から物体の基本的な形やテクスチャを識別する能力を学習させることが挙げられます。

一方で転移学習は、事前学習されたモデル(またはその重要な部分)を取り、それを新しいが関連性のあるタスクに特化させるプロセスです。

ここでの主な目的は特定のタスクにおける学習時間の短縮と性能の向上にあり、一般的な特徴を抽出する事前学習段階を経て、より具体的な問題解決のための微調整が行われます。例として、事前に一般的な画像を学習したモデルを使用して、特定の種類の犬を識別するタスクに適応させることが考えられます。

他にも、Googleが開発したInceptionモデルが広範な画像認識タスクで事前訓練され、後に医療画像分析や花の種類識別など特定のタスクに転移学習されたケースもあります。

転移学習と強化学習の違いは?

| 学習タイプ | 定義 | 主な特徴 | 一般的な応用例 |

|---|---|---|---|

| 転移学習 | あるタスクで得られた知識を別の関連するタスクに適用するプロセス。 | – モデルの一部または特徴を新たなタスクに再利用する。

– 新たなタスクに迅速に適応。 – データが少ない場合にも有効。 |

– 画像認識での種別識別

– 自然言語処理での言語間翻訳 |

| 強化学習 | 環境との相互作用を通じて最適な行動を学習するプロセス。 | – 試行錯誤に基づく学習。

– 報酬を最大化する行動を選択。 |

– ゲームプレイAIの開発

– 自動運転車の制御 |

転移学習と強化学習は、目的とする学習のメカニズムが根本的に異なります。

転移学習は、あるタスクで学んだ知識を別のタスクに適用することで学習時間の短縮や性能向上を図る手法ですが、これに対し強化学習は、環境からのフィードバックを基に最適な行動を学習するプロセスを指します。

強化学習の目標は、与えられた環境内で最大の報酬を得る行動戦略を見つけることです。

例えば、ビデオゲームのプレイや自動運転車の制御システムでは強化学習が用いられています。これらのシステムでは、連続的な試行錯誤を通じて何が最善の選択かを学習していきます。

一方、転移学習は例えば画像認識タスクで用いられ、一つのタスク(犬の画像分類)で得られた知識を似たタイプの新たなタスク(猫の画像分類)に活用します。

強化学習では、環境との相互作用を通じて「探索(新しい行動を試すこと)」と「搾取(既知の情報を最大限利用すること)」のバランスを取りながら学習を進める点が、転移学習と大きく異なる特徴です。

転移学習の3つのメリット

転移学習には、以下のメリットがあります。

- 学習する時間を短くできる

- 適用範囲を広げられる

- データが少なくても精度の高いモデルを作れる

上記3点についてそれぞれ解説していきます。

学習する時間を短くできる

転移学習の大きな利点の一つは、学習に必要な時間を大幅に短縮できることです。

通常、深層学習モデルをゼロから訓練するには膨大な量のデータと長時間の計算が必要ですが、転移学習を用いると、既に大規模データセットで訓練されたモデル(例えば、ImageNetで訓練された画像認識モデル)の知識を活用し、特定のタスクに対して必要な層のみを再訓練することにより学習時間を削減できます。

具体的な活用例としては、医療画像診断における転移学習が挙げられます。

一般的な画像認識で学んだ特徴抽出器を用いて特定の病気の診断を行うために微調整を行うことが可能で、これにより短期間で精度の高い診断モデルを開発することができ、医療現場での導入までの時間を短縮することができます。

適用範囲を広げられる

転移学習のもう一つのメリットは、学習済みのモデルがさまざまなタスクや異なるデータセットに容易に適応できることです。

これにより、異なるドメインや異なる問題に対しても基本的な学習構造を変えることなく、小さな調整や追加学習で対応することができます。

自動車メーカーが自動運転技術を開発する際、一般的な道路画像から学んだモデルを特定の気象条件や異なる道路状況に適応させるために転移学習を使用することが考えられます。

これによって新しい環境への適応を迅速に行うことができ、開発サイクルの加速が期待できるといえます。

データが少なくても精度の高いモデルを作れる

転移学習はデータが限られている状況でも高いパフォーマンスを発揮することができるため、データ収集が困難またはコストが高い分野で特に有効です。

特にラベル付けが必要な教師あり学習では、ラベル付け作業に多大な時間とコストがかかるため事前に訓練されたモデルを利用することが非常に効果的です。

新種の動物や特定の稀少種を識別するための生物学的研究では、限られた数の画像からでも高精度な分類モデルを構築する必要がありますが、転移学習を用いることで広範囲の動物画像で訓練されたモデルを基に、新たな種の特徴を迅速に学習して精度の高い分類が可能となります。

転移学習の2つのデメリット

転移学習は、既存のデータや知識から新たな問題解決へと知見を活かす方法として多くの分野でその価値が認識されていますが、その利用には制限があることも理解しておく必要があります。

- データ間の関連性に依存する

- 未開拓の領域だと使用できない

上記2点のデメリットについてそれぞれ見てきましょう。

データ間の関連性に依存する

転移学習の最大の課題の一つは、その成功が元のデータセットと新しいタスク間の関連性に大きく依存することです。

この関連性が十分に高くない場合、転移学習は非効率または効果が低いものになるため、例えば犬の画像で訓練されたモデルを使って自動車の画像を分類しようとすると、犬と自動車は視覚的特徴が大きく異なるためモデルの性能は著しく低下する可能性があります。

このような場合、モデルは負の転移を起こして間違った予測や分類を行うリスクが増大するといえます。

異なる種類のデータセット間での転移を試みる際には、データの特徴やカテゴリが根本的に異なることからそのまま転用することには限界があります。

他にも、医療画像分析で訓練されたモデルを衛星画像の解析に適用しようとした場合、両者の画像特性の違いから高い精度を期待することが困難なのは明白です。

このような問題を解決するためには、異なるドメイン間での転移前に適切なドメイン適応手法を施す必要があります。

未開拓の領域だと使用できない

転移学習は特に既に豊富なデータが存在する分野で有効ですが、新しく未開拓の分野やデータがほとんどない分野ではその効果を発揮しにくいという問題があります。

これは、転移学習が基本的には既存の知識を新しいコンテキストに適用することに依存しているためです。

未開拓分野では適切な事前学習モデルが存在しないことが多く、転移学習の初期段階で必要となる基礎的な知識が不足しているために有効な学習が行えないことがあります。

例えばある特定の稀少疾患に関する医療画像データがほとんど存在しない場合、一般的な医療画像で訓練されたモデルを使用しても、その稀少疾患の正確な診断には至らない可能性があります。

このような事象を解決するためには新しいデータセットから一からモデルを訓練する必要があり、これには膨大な時間とリソースが必要となるでしょう。

転移学習のやり方

転移学習を行う際は、決められた手順で行う必要があります。

ここでは、転移学習を行うための4つの手順について解説します。

事前学習モデルを選ぶ

転移学習を始める前に、まず「事前学習モデル」と呼ばれるすでに大規模データで学習済みのモデルを選びましょう。

画像認識ならResNetやVGG、文章の理解ならBERTやGPTなどがよく使われます。

選ぶ際は、新しいタスクにピッタリのモデルを見つけることがポイント。また、モデルがどんなデータを使って訓練されたかも確認して、それが新しいタスクに合っているかを判断するようにしましょう。

モデルの一部または全部を凍結をする

転移学習では、事前学習モデルの一部または全部を「凍結」することがよく行われます。凍結とは、すでに学習された知識を活かしつつ、新しいデータに適応させるための手法です。

モデルの初期層は基本的な特徴(例えば、画像ではエッジや形状など)を捉えるので、その部分を固定することが多いとされています。

一方で、新しいタスクに必要な部分は、自由に学習できるように凍結しないこともあります。こうすることで、既存の知識を活かしつつ新しいタスクにも柔軟に対応できるようになります。

新しいタスク用の層を追加する

次に、事前学習モデルの上に、新しいタスクに合わせた「層」を追加します。

例えば、画像を分類する場合、モデルの最後にある層を外して必要なクラス数に対応する新しい層をつけ加えます。新しい層は、追加されたタスクに特化して働くのです。

また、タスクに応じて適切なアクティベーション関数(ソフトマックスやシグモイドなど)を使うことで、より効果的にモデルが学習できるようになります。こうすることで、モデルが新しいタスクに向けた結果を出すようになります。

新しいデータでファインチューニングを行う

最後に、新しいデータを使ってモデルを微調整(ファインチューニング)します。

これは、すでに学習されたモデルを新しいタスクにぴったり合わせるためのに重要です。

凍結しなかった部分や新しく追加した層は、新しいデータを使ってしっかりと学習を進めます。

このとき、学習率を低く設定することで既存の知識を大きく変えずに細かな調整ができます。効率よく新しいタスクに対応できるモデルが完成します。

転移学習の応用例

転移学習は多くの分野でその価値が認識されており、特に以下の領域では効率的な進歩が遂げられています。

- 自然言語処理

- 画像解析

- 音声認識

転移学習の活用事例についていくつかピックアップして紹介していきます。

自然言語処理

自然言語処理において転移学習は、言語モデルの事前学習として有効に活用されています。

GoogleのBERT(Bidirectional Encoder Representations from Transformers)は、大量のテキストデータに基づいて事前に訓練されており、様々な言語タスクに対して微調整されることで特定のアプリケーションへ適用されています。

BERTの事前学習されたモデルは、感情分析、質問応答システム、テキスト要約などの様々なタスクに微調整することで、少ないデータ量で高いパフォーマンスを達成しています。

この事前学習と微調整のプロセスは多言語間での応用も可能で、例えば英語で学んだ文脈理解を日本語へ転用することなども行われています。

画像解析

画像解析では、転移学習を用いて特定の物体認識タスクにおいて既存のモデル(例えば、ImageNetで訓練されたモデル)を再利用しており、医療画像診断の分野での活用が典型例といえるでしょう。

皮膚がんの識別のために、一般的な物体認識で訓練されたモデルを基に皮膚病変の画像に特化して微調整することで、診断の精度を大幅に向上させることができます。

こうした転移学習を用いたアプローチは、訓練データが限られる医療分野において特に価値が高いとされています。

音声認識

音声認識分野でも転移学習は広く使われています。

特定のアクセントや言語に特化した音声認識システムを開発する際、一般的な英語音声認識モデルを基にして特定地域のアクセントや方言のサンプルで微調整を行うことで、システムの精度を向上させることが可能となっています。

さらに、この技術はスマートスピーカーや音声対応アシスタントなど、日常生活の製品にも応用されており、利用者の声の特性を学習することでより自然でスムーズな対話が実現可能となっています。

まとめ:転移学習とは機械学習の分野で注目を集めている

転移学習は一度学習したモデルを新たな課題に応用する手法で、データの少ない状況でも高精度のモデル構築を可能にしてくれます。

迅速な開発と精度の向上が求められる現代において、今後、転移学習は大きなメリットを与えてくれるでしょう。

Jiteraでは、要件定義を書くだけでAIがアプリ・システムを開発するプラットフォームJiteraを軸としてさまざまなアプリ・システム開発を行っており、企業が直面する技術的な課題を解決するための様々なソリューションを提供しています。

今回のテーマである転移学習をはじめ、AIを活用したシステム開発は株式会社Jiteraの最も得意とする領域です。

もし現在、転移学習やその他AIに関してお困りごとのある方は、ぜひ株式会社Jiteraにご相談ください。

これまでの経験や知識を元に、ビジネスに最適なご提案とサポートをさせていただきます。