近年、機械学習の分野で注目を集めているのがブースティングです。

しかし、ブースティングとは一体なんなのかを理解していない方も多いのではないでしょうか。

この記事では、ブースティングの基本的な概念から、その意味や目的、さらには具体的な利用例までをわかりやすく解説します。

機械学習の精度を向上させるための手法として、ブースティングを理解でき、活用できるような内容をお届けしますので、ぜひ参考にしてみてください。

現役のシステムエンジニアとして10年程度のキャリアがあります。 Webシステム開発を中心に、バックエンドからフロントエンドまで幅広く対応してきました。 最近はAIやノーコードツールも触っています。

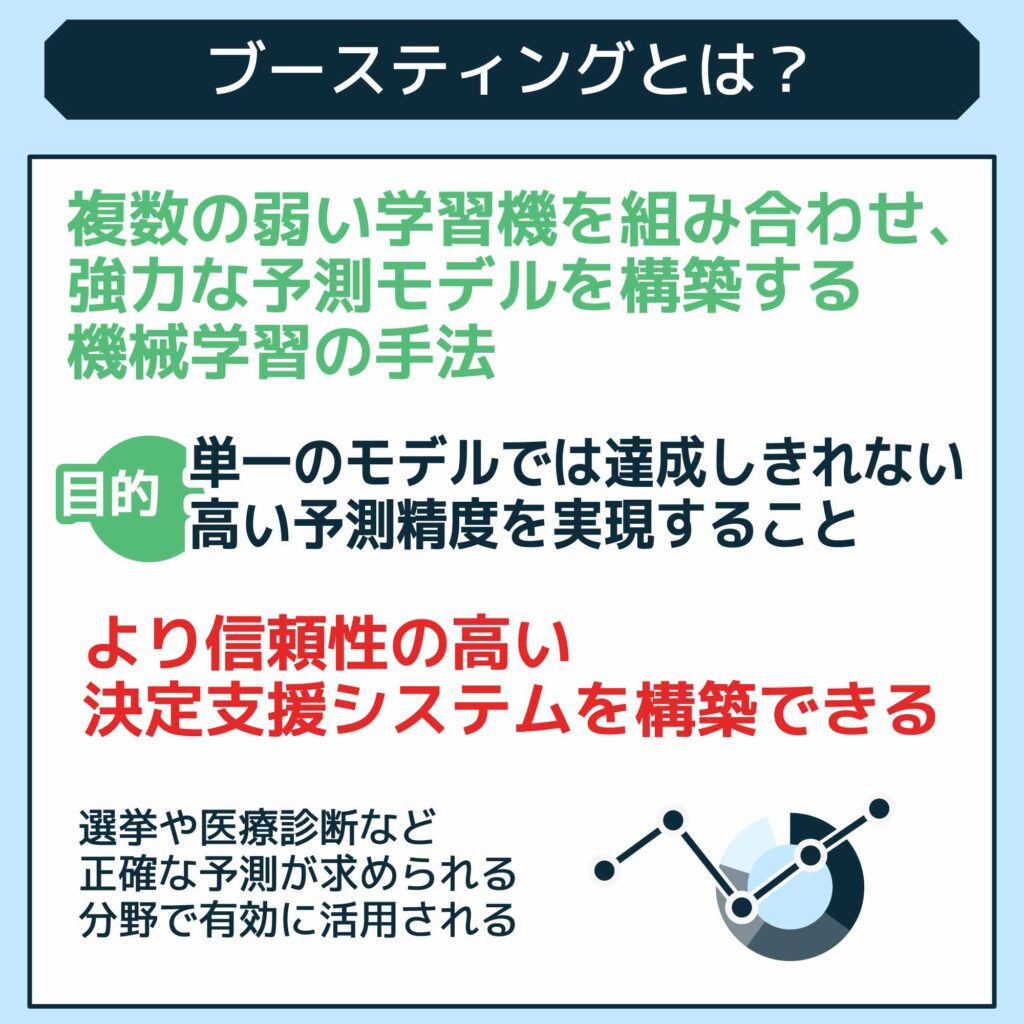

ブースティングとは?

ブースティングとは、複数の弱い学習機を組み合わせて、より強力な識別器を構築する機械学習の手法です。

この技術を用いることで、個々のモデルが持つ予測の弱さを補い合い、予測モデル全体の精度向上につながります。

たとえば、簡単な決定木(機械学習のデータ構造)を何層にも重ねることで、より正確な予測可能です。この過程で、各モデルの予測に基づいて、次のモデルが重点的に改善するべき誤りを特定していくことで、全体の性能が段階的に向上します。

この手法は、特に分類問題や回帰問題において有効であり、正確な予測をする上で非常に便利です。

ちなみに、ブースティングに似た技術としてバギングというものもあります。

バギングもアンサンブル学習の一種ですが、ブースティングとは学習方法が異なります。

バギングでは、複数の弱学習器(識別器)を並列に学習させ、その結果を統合することで予測精度を向上させます。一方、ブースティングでは、弱学習器を逐次的に学習させ、前の弱学習器の誤差を修正するように次の弱学習器を学習させます。

このように、ブースティングとは、複数の弱い学習器を組み合わせることで、高精度な予測モデルを構築する手法だと覚えておきましょう。

ブースティングの仕組み

ブースティングは、複数の弱い学習器を組み合わせて強力な予測モデルを構築する手法です。

各弱学習器は、前のモデルが誤った予測をしたデータに重点を置いて学習を進め、誤差を修正していきます。このプロセスを繰り返すことで、高精度で強力な予測モデルを構築していきます。

ブースティングは以下の仕組みで構築されます。

- 初期モデルの作成

- 誤差の計算

- 新モデルの追加

- モデルの統合

- 指定回数や精度まで繰り返す

それぞれについて見ていきましょう。

1. 初期モデルの作成

ブースティングのプロセスは、初期モデルの作成から始まります。まずは、トレーニングデータを用いて単純なモデル(弱学習器)を作成します。

この初期モデルは、データの基本的なパターンを捉えることを目的としていますが、精度はまだ高くありません。この段階では、モデルがどのようにデータを解釈するかの基礎を築くことが重要です。

2. 誤差の計算

初期モデルが作成された後、次に行うのは誤差の計算です。これは、モデルの予測と実際の結果との誤差を計算します。

この誤差は、後続のステップで新たなモデルを生成するときの重要な指針となります。誤差が大きいデータポイントは、次の学習ステップで重点的に改善されるべき対象として識別されます。

3. 新モデルの追加

前のステップで計算された誤差に基づいて、新しいモデル(弱学習器)を追加します。

この新モデルは、前のモデルで誤差が大きかったデータポイントに対してより良い予測を行うように設計されています。

具体的には、誤差が大きかったデータに大きな重みを与え、そのデータをより重視して学習することで、精度向上を目指します。

4. モデルの統合

新たに追加されたモデルと、既存のモデルを統合します。これは、各モデルの予測を重み付けして組み合わせることで行われ、全体としてより精度の高い予測を実現します。

各モデルの重みは、そのモデルの精度に基づいて決定されます。

具体的には、精度の高いモデルほど、大きな重みが与えられ、最終的な予測結果への影響が大きくなります。

この統合プロセスにより、個々のモデルの弱点が補われ、より強力なアンサンブルモデルが形成されます。

5. 指定回数や精度まで繰り返す

ステップ2から4を、指定された回数繰り返すか、モデルの精度が一定のレベルに達するまで繰り返します。

この繰り返しによって、徐々にモデルの精度が向上していきます。 繰り返し回数は、データ量やモデルの複雑さなどによって調整する必要があります。

主なブースティングアルゴリズムの種類と特徴

ブースティングアルゴリズムには、それぞれ異なる特徴を持つ様々な種類が存在します。

ここでは、代表的な4つのアルゴリズム、AdaBoost、Gradient Boosting、XGBoost、LightGBMについて、その特徴と違いを解説します。

今回紹介するアルゴリズムの比較表は以下のとおりです。

| アルゴリズム | 特徴 | メリット |

| AdaBoost | 弱学習器を順次追加し、前回誤分類したデータに重みを付けて学習することで、徐々に精度を向上させる | シンプルで理解しやすいアルゴリズム |

| Gradient Boosting | 誤差を最小化するための勾配降下法を使用し、より複雑な関係性を学習できる | 高い精度が期待できるが、計算コストが高い |

| XGBoost | 効率よく欠損値処理も可能な勾配ブースティングアルゴリズム | 複雑なモデルでも扱いやすい |

| LightGBM | ヒストグラムベースのアルゴリズムを採用し、学習速度が速く、メモリ効率が良い | スケールが良く、大規模データセットに適している |

以下では各アルゴリズムについて紹介します。

AdaBoost

AdaBoost(アダブースト)は、複数の弱学習器を順次追加し、誤分類したデータに重みを付けて学習する手法です。

誤分類されたデータに大きな重みを与え、次の弱学習器が重点的に学習するように調整することで、全体的な精度を向上させます。

比較的単純なアルゴリズムであるため解釈が容易というメリットがありますが、ノイズや外れ値に敏感であるという弱点も持っています。

Gradient Boosting

Gradient Boostingは、勾配降下法を用いて誤差を最小化する手法です。各ステップで誤差を計算し、その誤差を縮小するように次の弱学習器を追加します。

AdaBoostよりも汎用性が高く様々なタスクに適用できますが、計算コストが高く学習に時間がかかるというデメリットもあります。

XGBoost

XGBoost(eXtreme Gradient Boosting)は、Gradient Boostingをもとに開発されたアルゴリズムで、高効率な欠損値処理や並列計算を特徴とします。これにより、複雑なモデルでも効率的に扱うことができ、特に大規模データセットに対して有効です。

XGBoostは、汎用性、精度、速度のバランスが良く、人気があるアルゴリズムとして多くの利用者に使用されてます。

LightGBM

LightGBMは、ヒストグラムベースのアルゴリズムを採用することで、より高速な学習を実現しているアルゴリズムです。 大規模なデータセットでも効率的に学習できるため、近年注目を集めています。

LightGBMは、従来の勾配ブースティングアルゴリズムと比較して、非常に高速で効率的です。特に大規模なデータセットに対しても高精度で高速という高いパフォーマンスを発揮できるという特徴があります。

ブースティングのメリット

ブースティングを活用すると、単一のモデルでは達成しきれない高い予測精度を実現できます。

たとえば、何枚かの簡単な決定木を組み合わせることで、複雑なデータのパターンを捉え、誤分類を削減できます。さらに、各モデルが他のモデルの弱点を補完するように働くことで、全体としての性能が向上します。

このようにブースティングには以下のようなメリットがあります。

- 高精度な予測モデルの構築ができる

- 過学習が防止できる

- 実装が簡単で柔軟性も高い

- モデルの解釈性が向上する

- 計算効率が良い

それぞれ詳しく解説します。

高精度な予測モデルの構築ができる

ブースティングを構築する過程では、1つ1つの学習器が前の学習器が苦手とした部分に焦点を当て、特に難しい問題には力を入れて取り組みます。

たとえば、最初のモデルが分類できなかったデータポイントに、次のモデルが重点を置きます。このプロセスを繰り返すことで、全体として見逃されがちなパターンや隠れた相関関係を捉える能力を高めることが可能です。

この積み重ねを行うことにより、最終的には単一の強学習器では達成しえない精度を持った予測モデルが完成します。

このようにブースティングは、複数の小さな力を結集させて大きな力を生み出す戦略であり、予測タスクにおける効率と精度を大幅に向上させるのです。

過学習が防止できる

1つの学習器が特定の学習データに過剰に適合してしまう、いわゆる「過学習」を防ぐことが可能です。

各学習器は比較的単純なモデルで構成されているため、過学習しにくい性質を持っています。

たとえば、複数のシンプルな決定木を組み合わせた場合、それぞれの決定木はデータの一部の特徴にのみ焦点を当てており、全データの複雑な関係性やノイズへの影響は少ないという特徴があります。

そのため、個々のモデルが過学習するリスクが抑えられます。

さらに、組み合わせることでその弱点を補いながら、より汎用性の高い強力なモデルを構築可能です。

この戦略により、ブースティングは多様なデータに対して堅牢な予測性能を発揮し、過学習のリスクを効果的に低減することが期待できます。

実装が簡単で柔軟性も高い

実装のしやすさもブースティングのメリット1つです。

既存のシンプルなモデルを積み重ねることで高精度の予測が可能になるため、複雑なアルゴリズムを1から設計する必要がありません。

たとえば、弱学習器としてよく使われる決定木は、その理解しやすさと計算の速さから初心者にも扱いやすく、これをもとにブースティングを行うライブラリも多く提供されています。

また、各学習器は独立して学習されるため、エラーが発生してもその部分のみ修正すればよく、全体のシステムに波及するケースが少ないです。

このように、ブースティングは初心者でもアクセスしやすく、既存の簡単なモデルを用いて効果的に性能を向上させることができるため、多くの実務で採用されています。

その結果、より少ない労力で高い成果が期待できます。

モデルの解釈性が向上する

ブースティングは、複数の 弱学習器 を組み合わせることで、複雑なモデルを構築します。異なる種類のエラーに対応する複数の決定木を組み合わせることで、各モデルが他のモデルの誤りを補正し合う効果が生まれます。

この相互作用により、予測の際の不確実性が減少し、全体としての予測の精度が向上します。データに含まれる潜在的なバイアスやノイズの影響を軽減し、よりリアルなデータの挙動を反映したモデルを作り出すことに貢献します。

その結果、予測モデルの信頼性が高まり、実際の問題解決においてもより確かな判断が可能になるのです。

計算効率が良い

機械学習モデルの学習には、多くの計算処理が必要です。特にデータ量が多い場合、学習に時間がかかってしまうことがあります。

ブースティングは、弱学習器を逐次的に学習させていくため、一度に全てのデータを処理する必要がありません。そのため、他の複雑なモデルと比較して、計算効率が良いというメリットがあります。

特にXGBoostやLightGBMのような最適化されたアルゴリズムは、並列計算や効率的なメモリ管理を活用することで、計算効率を高めています。

このような特徴によって大規模なデータセットに対してもスケーラブルに対応できるようになっている点もブースティングのメリットのひとつです。

ブースティングのデメリット

ブースティングはたくさんのメリットがある一方で、デメリットも存在します。ここでは、主なデメリットを解説します。

- 外れ値が出ると対応しにくい

- リアルタイムで実装できない

- ハイパーパラメータの調整が難しい

- 計算コストが高くなる場合がある

それぞれ詳しく解説します。

外れ値が出ると対応しにくい

ブースティングのデメリットは、外れ値に対しては対応が難しさがある点です。

ブースティングは、誤りやすいデータポイントに次第に重点を置いて学習を進めるため、外れ値が多いとそれらに過度に影響を受けることがあります。

たとえば、データセットに異常なほど大きな値や全く関連のない値が含まれている場合、これらの点に着目し、結果として全体のモデルの一般化能力が低下する可能性があります。

これにより、実際の運用環境での予測性能が期待よりも低くなる場合が少なくありません。

この問題に対処するためには、データ前処理段階で外れ値を適切に処理するか、ブースティングを行う際に外れ値の影響を低減する手法を検討する必要があります。

リアルタイムで実装できない

ブースティングはその予測精度の高さから多くの場面で利用されていますが、リアルタイム処理には向かないというデメリットがあります。

なぜなら、複数のモデルを順番に学習させ、それぞれの予測を統合する必要があるため、計算に時間がかかるからです。

たとえば、オンラインでのユーザー行動をリアルタイムで予測しようとする場合、ブースティングはデータを収集してから予測を出すまでのレイテンシーが大きく、即時反応が求められる環境では適切ではありません。特に、トランザクション処理や緊急対応が必要なシステムでの利用が困難です。

ちなみに、このようなシーンでは、一般的により軽量で迅速な処理が可能な他の機械学習モデルを採用します。

ハイパーパラメータの調整が難しい

ハイパーパラメータとは、モデルの学習前に設定するパラメータのことです。学習率や木の深さなどが挙げられます。

ブースティングアルゴリズムは、学習率や木の深さなどのハイパーパラメータが多数存在します。これらのパラメータを適切に設定することで、モデルの性能を向上できます。

しかし、ハイパーパラメータの最適な値はデータセットやタスクによって異なるため、調整が難しい場合があります。

最適なハイパーパラメータを見つけるためには、試行錯誤が必要となることが多く、専門知識や経験が求められます。

計算コストが高くなる場合がある

ブースティングは、弱学習器を複数組み合わせるため、計算コストが高くなる場合があります。

特に、データ量が多い場合や、複雑なアルゴリズムを使用する場合は、計算時間やメモリ使用量が増大し、リソースの制約が問題となることがあります。

このため、計算資源が限られている環境では、ブースティングの使用が難しい場合があります。

ブースティングの具体例

最後に、ブースティングの具体例を4つ紹介します。

- クレジットカードの不正利用検出

- オンラインゲームにおける不正

- 効果的なマーケティング

- 運輸・物流業務の最適化

これらの例を参考にすることで、ブースティングへの理解を深めていきましょう。

クレジットカードの不正利用検出

ブースティングはクレジットカードの不正利用検出で用いられる場合が多いです。

まず、異なる種類の決定木を利用して各種の取引パターンを分析します。初めのモデルが一般的な不正の兆候を捉え、次のモデルは前のモデルが見逃した細かな異常を特定可能です。

このプロセスを繰り返すことで、通常の消費者行動とは異なる微妙な違いを検出できるようになります。

この機能によって、クレジットカードの不正使用の疑いがある取引を高い精度で識別することが可能です。

また、不正利用のテンプレートを設定する従来の手法とは異なり、不正手法が出現しても柔軟に対応できるため、金融業界で非常に重宝されています。

このようにブースティングを活用することで、金融機関は顧客の資産を守り、信頼性の高いサービスを提供できます。

オンラインゲームにおける不正

オンラインゲームにおける「ブースティング」とは、通常、ゲーム内のランキングやスキルレベルを不正に上げる行為を指します。この行為には主に以下二つの形態があります。

- 高い技術を持つプレイヤーが別のプレイヤーのアカウントを使用してゲームをプレイする

- 意図的に低いレベルのプレイヤーとマッチングして簡単に勝利を積み重ねる

このようなブースティングは、ゲームの公正性を損ない、他のプレイヤーのゲーム体験に負の影響を与えます。

プレイヤー同士の競争が行われるゲームでは、プレイヤー間のスキルや実力に基づく公平なマッチングが重要ですが、ブースティングによりそのバランスが崩れることになります。

その結果、不正にランクが上がったプレイヤーが実際の能力に見合わない高いランクに位置してしまい、マッチングされる他のプレイヤーにとっては不快な経験となることが多いです。

オンラインゲームの運営者はこの問題に対処するために、ブースティングを行うアカウントへの罰則を設けたり、マッチングシステムの改善を行ったりしています。

運営者はゲームの公正性を保ち、すべてのプレイヤーに平等で楽しい環境を提供することを目指すべきです。

効果的なマーケティング

マーケティング分野では、顧客の購買行動を予測するためにブースティングが使用されています。

顧客データを分析し、購入の可能性が高い顧客を特定することで、ターゲットを絞った効果的なマーケティング施策を実施できます。

例えば、特定の商品に興味を持ちそうな顧客に絞って広告を表示することで、広告の費用対効果を高めることが期待できます。

これにより、広告費の最適化や売上の向上が期待できます。

運輸・物流業務の最適化

近年、物流業界では、配送ルートの最適化や需要予測などにブースティングが活用されています。

過去の配送データや交通情報などを分析することで、より効率的な配送ルートを計画したり、将来の需要を予測したりすることができます。

例えば、配送ルートの最適化によって、配送にかかる時間やコストを削減し、顧客満足度を向上させることができます。

このように過去のデータセットから有益なパターンを抽出し、業務の効率化を実現しています。

まとめ:ブースティングは機械学習において精度を上げる手法

この記事では、ブースティングについて詳しく解説しました。

ブースティングは、複数の弱い予測モデルを組み合わせ、それらを強化することで全体としてより強力な予測モデルを作り上げる機械学習の手法です。

その精度の高さと実装の手軽さから、多くの領域で利用されています。ただし、外れ値に対する対応やリアルタイム処理が難しいといったデメリットも存在します。

今回紹介した内容も参考に、ブースティングの知識を深めてみてはいかがでしょうか。

また、ブースティングなどの機械学習技術は、Jiteraでも活用しています。

Jiteraは、要件定義を書くだけでAIがアプリ・システムを開発するプラットフォームを提供しており、ブースティングのような高度な機械学習技術を用いて、より精度の高いシステム開発を実現しています。

AIや機械学習を活用してシステム開発を効率化したい人は、ぜひJiteraを活用してみてください。